國華的世界

這是國華對讀過的書, 看過的電視/電影, 聽過的音樂, 訪遊過的地方, 經曆過的事物, 和時事的感想或點評.當美國開放式人工智能(Open AI)的GPT-3模型(下圖 analiticSteps)在2020年6月首次發布時,它的性能被廣泛認為是最先進的,其技術已超越 AlphaGo 。GPT-3是語言模型中的全能學霸,他不僅會寫短文,而且寫出來的作文挺逼真的,幾乎可以騙過人類,據說幾乎通過了圖靈測試。在無監督下的自主學習能力非常強,GPT-3能夠從人類精心製作的散文中生成難以辨認的文本,從而為深度學習樹立了新的標準。通常,一個語言模型首先要能理解自然語言,比如給出兩個句子,語言模型會判斷哪個句子更像自然語言、句子裏麵的詞或短語的依賴關係是什麽;其次,語言模型能對自然語言做預測,如隻給出一句話的前幾個字,語言模型根據語言規律來預測後麵的字是什麽。GPT-3 完全具備這兩項能力。GPT-3 的厲害之處可以用三個詞來總結:多任務(multi-task)、無監督(unsupervised)、小樣本動態學習(few-shot learning)。

具體來說,GPT-3之前的模型一般隻能處理單一的任務,對每一個應用場景都要單獨訓練模型。比如針對翻譯考試要單獨訓練一個翻譯模型,針對做數學題要單獨訓練一個數學模型。但是 GPT-3 可以在單一模型裏處理多個任務,而且每一個任務都處理得不錯,仿如一位科科都得高分的全才學生。另外,考試的時候,GPT-3 可以應對人類自由風格的綜合麵試,人們可以在自然的對話中隨意出題,問題可以是天文、地理、曆史、算術等穿插著進行。GPT-3保證回答完美,最終以參考生中的最高得分手勝出。

本身就這麽優秀了,它還非常自律,GPT-3在學習過程中完全不需要監督、非常積極主動,且自學能力爆棚,學習過程中根本無需人們提供有答案的練習題來複習測驗(微調模型)。

隻要給他提供無限多的文本序列,GPT-3就能自動從文本裏學到各種知識。其學習成長經曆,就像從一個咿呀學語的小孩開始,在教會他最基本的拚音識字(類似於 GPT 裏的數據編碼)後,給他《世界通史》《四大名著》《算數啟蒙》(下圖 Google Images)等各類書籍,他就會開始主動地自學,不需要老師輔導或向誰請教。前麵講到語言學習,這兒再以寫計算機程序為例。以前都是人類去寫程序。現在有了GPT-3,人類寫一個人工智能算法後,算法自己即可從數據中推導出程序。就這樣通過一段時間的自學,GPT-3將會成為一個不偏科的跨學科學霸。

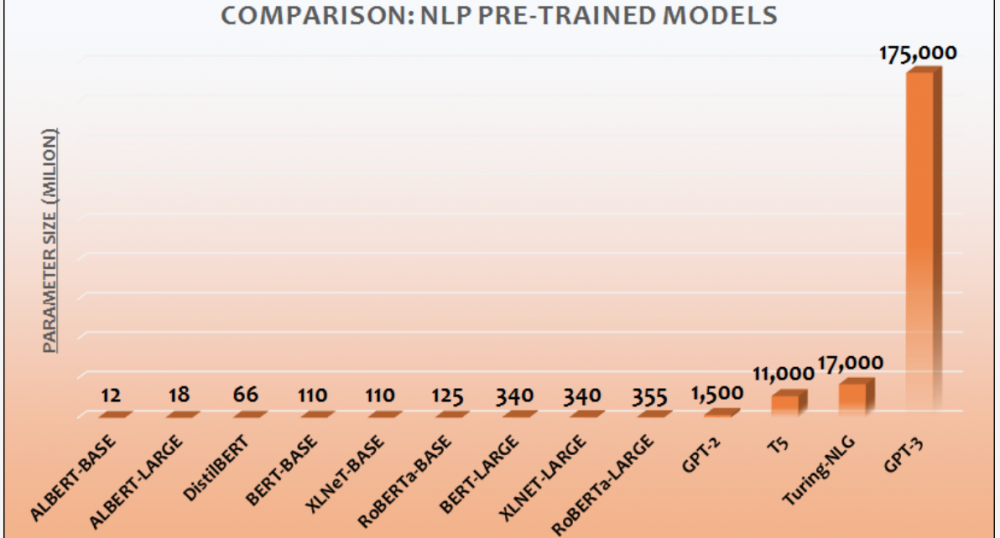

GPT-3能夠做到這些,是因為該算法模型接受了1750億個參數,跑通了新的人工智能技術路線,以及雄厚的財力和(科技)人力(下圖 asb)。訓練超大GPT-3模型,須使用超大規模GPU機器學習集群。人工智能模型訓練一次的花銷是千萬美金,而一顆衛星的製造成本已經降到50萬美元以下。OpenAI還有足夠的相關領域人才從技術上保障項目的成功。GPT-3 是幾十人的有組織的係統性合作,有人出主意、有人搞數據、有人寫代碼、有人做實驗、有人做評測。模型參數從1750 億,這本身就是巨大的工程挑戰,需要那種既懂基礎算法、又有超強的工程能力的科學家和工程師一起通力協作才有可能做成。雖然運行人工智能模型比衛星成本還昂貴,但OpenAI的錢袋深,不缺錢,耗得起。

得,如此之多的溢美之詞,還不知道GPT-3的應用的場景如何呢。你別說,應用的場景多著呢 -- GPT-3基本是一個增強版的搜索引擎或 AI 助理, 它可以回答問題、編程、寫新聞稿、數學推理、做財務報表…… 信不信由你,很快GPT-3 語言方麵的能力就要超過 99% 人類了。這是否意味著大部分人將失業呢?不知道,但肯定從事AI的人是不會的。也不用過分焦慮,曾經出現的許多新技術、新事物,不是也創造出許多新的就業機會嗎?抱歉,此乃題外話。

最後咱來認識認識GPT-3的研發者OpenAI(開放式人工智能實驗室) (下圖1)。顧名思義,這是美國一家從事人工智能(AI)研究的科技企業,據認為是世界三家頂級AI實驗室之一,由盈利公司(OpenAI LP)及其母公司非盈利開放式人工智能(OpenAI)公司組成。除GPT-3外,OpenAI的人工智能圖像生成器 DALL-E也在AI界廣為人知。OpenAI被認為是穀歌DeepMind在人工智能領域研究的競爭對手。OpenAI創立的時間並不長 -- 由伊隆·馬斯克 (Elon Musk)、薩姆·奧特曼(Sam Altman) (下圖2 Google Images)和其他人共同出資10億美元2015年底在舊金山成立。馬斯克於2018年2月從董事會辭職,原因是與特斯拉人工智能自動駕駛汽車的開發存在“未來潛在的利益衝突”, 不過馬斯克一直保持捐贈者的身份。2019年,OpenAI LP獲得了微軟10億美元的投資。OpenAI的董事長兼首席技術官為格雷格·布羅克曼(Greg Brockman),任職OpenAI前,他曾擔任愛爾蘭/美國金融服務和軟件服務公司Stripe的首席技術官,也是Stripe的第三名員工。OpenAI的首席科學家/研究總監為伊利亞·薩茨凱沃( Ilya Sutskever),之前曾在穀歌出事人工智能研究工作,擔任穀歌機器學習專家。OpenAI的首席執行官薩姆·奧特曼(Sam Altman)也是OpenAI的創立人之一。此前,他任職創業加速器Y Combinator,擔任總裁.

GPT-3發布後OpenAI LP一時間風光無兩,前/錢途一派光明,似乎就坐等各種商用開發,然後在家數錢就行了。可科技進步無止境,江山代有人才出。這不,GPT-3發布一年之後,超越它的新型人工智能模型就問世了。競爭,果然是激烈地,尤其當競爭是在美國和其的頭號競爭對手中國大陸間展開的時候。欲知後事,請待下文分解。

未完待續

參考資料

在野. (2020). 對話出門問問李誌飛:GPT-3 是「暴力美學」的一次勝利. GEEKPARK. 鏈接 https://www.geekpark.net/news/263849

智源社. (2021). 區智源x清華開源FastMoE,萬億AI模型基石. CSDN. 鏈接 https://blog.csdn.net/BAAIBeijing/article/details/114389119

譚婧. (2020). 史上最大,人工智能算法模型GPT-3問世,這意味著什麽? 澎湃. 鏈接 https://www.thepaper.cn/newsDetail_forward_8052804

BAAI. (2021). BAAI. 鏈接 https://www.baai.ac.cn/en

Bama, A. (2021). This Chinese Super Scale Intelligence Model, ‘Wu Dao 2.0’, Claims To Be Trained Using 1.75 Trillion Parameters, Surpassing All Prior Models to Achieve a New Breakthrough in Deep Learning. MARKTECHPOST. 鏈接 https://www.marktechpost.com/2021/06/13/this-chinese-super-scale-intelligence-model-wu-dao-2-0-claims-to-be-trained-using-1-75-trillion-parameters-surpassing-all-prior-models-to-achieve-a-new-breakthrough-in-deep-learning/

Black, D. (2021). China now has the most powerful neural network: it is many times smarter than competitors from Google and Open AI. World Stack Market. 鏈接 https://www.worldstockmarket.net/china-now-has-the-most-powerful-neural-network-it-is-many-times-smarter-than-competitors-from-google-and-open-ai/

He, H. (2021). China’s GPT-3? BAAI Introduces Superscale Intelligence Model ‘Wu Dao 1.0’. Synced Global AI Weekly. 鏈接 https://medium.com/syncedreview/chinas-gpt-3-baai-introduces-superscale-intelligence-model-wu-dao-1-0-98a573fc4d70

Naik, A.R. (2021). Wu Dao 2.0: China’s Answer To GPT-3. Only Better. AIM. 鏈接 https://analyticsindiamag.com/wu-dao-2-0-chinas-answer-to-gpt-3-only-better/

OpenAI. (2021). About. 鏈接 https://openai.com/about/

Tarantola, A. (2021). China's gigantic multi-modal AI is no one-trick pony. yahoo!finance. 鏈接 https://finance.yahoo.com/news/chinas-gigantic-multi-modal-ai-is-no-one-trick-pony-211414388.html

Wiki. (2021). OpenAI. 鏈接 https://en.wikipedia.org/wiki/OpenAI

“科普得很好。”

“還有人嘮嘮叨叨說要多生小孩兒麽?”

“天哪!你的第一段就把我一腔的導師的”音聲認識“的研究,用如此形象的文字如實地介紹給了讀者,引人入勝!

今早,這裏的早間國際新聞報道了在上海(好像是)的AI展覽會,“人機共存的時代” 來到了!”

“科普得好。”

"難得的好文章"

今早,這裏的早間國際新聞報道了在上海(好像是)的AI展覽會,“人機共存的時代” 來到了!