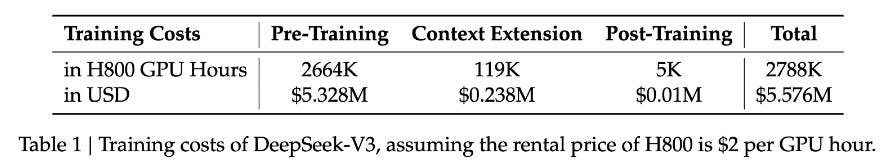

沒有貶低李飛飛教授的論文價值,但的確是兩個不同的東西。上圖是V3最後一輪的訓練得出穩定模型花費的算力。

DeepSeek 使用了14.8 trillion token(14,800,000,000,000)訓練它的V3模型。僅考慮將這些token的文本,大概是14800 terabytes。如果將這些文本上傳到AWS的S3存儲,每月的存儲費用是大概35萬美元。將所有的數據上傳至AWS要花費(假設每個文本文件5MB)大約1.5萬美元。李飛飛教授論文中的數據是1千條數據。是從Google Gemini裏拷貝下來的的。這兒是數據的鏈接:https://huggingface.co/datasets/simplescaling/s1K/viewer/default/train?row=0?

訓練數據是6.88MB。6.88MB(6個0) VS 14800 TeraBytes(12個0)。從工程角度完全不是一個數量級。很驚詫文學城裏許多人因為政治或其他原因不能理智客觀的評價國內的開源模型。